Update: Nog een geweldige analyse van de prestatie van AlphaStar kun je hier vinden. Misschien is deze AI nog geweldiger dan ik al dacht!

Hallo wereld,

Vandaag ga ik het hebben over de nieuwste creatie van Google’s DeepMind: AlphaStar. AlphaStar is een AI die afgelopen maand 2 professionele StarCraft II spelers elk met 5-0 heeft verslagen. Echter, na een kleine aanpassing in het programma wist de laatste van de twee spelers, MaNa, nog een wedstrijd terug te winnen. Desalniettemin was de prestatie van AlphaStar indrukwekkend.

DeepMind had al eerder professionele spelers verslagen in strategische spellen. AlphaGo had de topspelers van het bordspel Go al verslagen, en ook de schaak- en shogi-wereld konden niet op tegen DeepMind’s AlphaZero. OpenAI, een non-profit opgericht door Elon Musk en Sam Altman, versloeg in 2017 al een professionele speler in het real-time actie spel Dota 2 in een 1vs1 wedstrijd.

AlphaStar is echter de eerste AI die het voor elkaar heeft gekregen om een professionele speler te verslaan in een spel zo complex als StarCraft II. Een real-time-strategy game (RTS) met eindeloos veel manieren om het te spelen, waarvan slechts een zeer beperkt aantal effectief zijn. Het team van AlphaStar beweert op de blog-pagina dat AlphaStar won omdat het superieur was in zowel kleinschalig (micro) als grootschalig (macro) strategisch beslissing maken. Echter, na het zien van de demonstratie en een aantal analyses van de herhalingen ben ik het daar niet helemaal mee eens.

Persoonlijk ben ik van mening dat hoewel de macro van AlphaStar zeker indrukwekkend is, de micro de reden is waarom het in staat is om te winnen van een profspeler zoals MaNa. Dat is goed te zien in deze analyse van de video. Wel moet ik toegeven dat AlphaStar zijn macro strategie goed aanpast aan zijn superieure micro vaardigheden, door middel van bijvoorbeeld het kiezen van de meest geschikte units om mee te manoeuvreren, Stalkers en Phoenixs.

Wie ben ik om daar een uitspraken over te doen? Ik ben geen AI-expert, ik ben niet eens een StarCraft II speler. Maar, ik ben een mens met een brein, en af en toe gebruik ik het ook. Ik heb ook een heleboel casts gezien van professionele StarCraft II wedstrijden (vraag me niet waarom), en natuurlijk de demonstratie en een aantal analyses van de wedstrijden van AlphaStar zelf. Ook weet ik op basis van eigen onderzoek en experimentatie wel het een en ander over AI af. Ik verzoek je echter om mijn uitspraken op hun inhoud te beoordelen, niet op mijn achtergrond. Mocht je op basis van die inhoud concluderen dat deze uitspraken idioot (of geniaal) zijn dan hoor ik het graag.

Maar, de reden dat ik dit bericht schrijf is niet om te oordelen of AlphaStar zijn wedstrijden tegen MaNa eerlijk won. Ik denk dat een eerlijkere versie van AlphaStar zeker interessant zou zijn voor StarCraft spelers, maar niet per se voor de mogelijkheden van AI. Wat echt interessant is om hier op te merken is dat AlphaStar, zelfs met de beperkingen die het opgelegd gekregen had om het eerlijk te maken, in staat was om professionele spelers te verslaan! Nu al! Een spel met zoveel complexiteit dat het onmogelijk is om alle verschillende strategieën in alle verschillende situaties uit te rekenen.

Hoe heeft DeepMind dat gedaan? Door een combinatie van supervised learning (onder toezicht leren) en een speciale implementatie van reinforcement learning (leren door beloningen) genaamd de AlphaStar league.

In de supervised learning fase wordt het neurale netwerk getrained door het observeren van herhalingen van spellen tussen menselijke spelers. Dit stelt AlphaStar in staat om in korte tijd een competitief niveau te bereiken. In een spel zoals StarCraft zijn er enorm veel (1026 werd genoemd in een van de analyses) manieren zijn om het spel alleen al te beginnen, laat staan om het van begin tot eind te spelen. Zonder deze instructie zou AlphaStar er waarschijnlijk lang over doen om er achter te komen wat het moet doen om het spel te spelen, laat staan om het te winnen.

Vervolgens wordt het resultaat van deze fase gekopieerd en gemuteerd, en spelen deze verschillende “agents” tegen elkaar in een gesimuleerd toernooi, de AlphaStar league. De winnaars komen steeds verder in dit toernooi en op basis van kleine aanpassingen en de introductie van nieuwe agents worden ze dan stap voor stap verbeterd. Hierbij werden een aantal technieken toegepast om er voor te zorgen dat deze verbetering naar wens plaats kon vinden, maar daar kun je het beste meer over lezen op de blog. Het eindresultaat dat tegen MaNa speelde was een groep van 5 van die agents die elk het equivalent van 200 jaar real-time StarCraft ervaring hadden!

Wat betekent dit nu voor de toepassingen in de echte wereld? Nou, DeepMind heeft hier bewijs gegeven dat de combinatie van supervised en reinforcement learning in staat is om problemen op te lossen met enorme complexiteit. De overwinning over de schaakwereld was een heel ander verhaal, hierbij werd alleen een AI gecreëerd die in principe niets anders was dan een hele sterke schaak rekenmachine. De supervised versie alleen was niets anders dan een copycat van de strategieën die al door mensen toegepast worden.

Maar AlphaStar is meer dan dat, AlphaStar is een methode die gebruikt kan worden om niet alleen de menselijke capaciteit voor het oplossen van complexe problemen te evenaren, maar zelfs te ontstijgen. En hoe sterker de rekenkracht van onze computers zal worden, hoe groter de mogelijkheden van de AI die ermee gecreëerd wordt.

In een van de analyse wordt dan ook de grap gemaakt dat AlphaStar de eerste voorloper is van SkyNet. Nu denk ik zelf niet er ooit iets zo barbaars en inefficiënt in het uitroeien van de mensheid zal ontstaan als SkyNet, maar er zijn zeker risico’s waar we ons van bewust moeten zijn. Maar, er zijn natuurlijk ook een hele hoop positieve toepassingen te bedenken.

Op dit moment hebben we bijvoorbeeld al een begin gemaakt in het creëren van zelf rijdende auto’s. Hoewel die programma’s statistisch gezien al betrouwbaarder zijn dan mensen zelf, maken ze af en toe nog steeds verschrikkelijke fouten wanneer ze gepresenteerd worden met onbekende situaties. Situaties waar mensen zich met gemak aan zouden kunnen aanpassen, maar waar AI met beperkte rekenkracht niet weet hoe het er mee om moet gaan.

Dit is dan ook de reden, of een van de redenen, dat MaNa in staat was om de laatste wedstrijd tegen AlphaStar te winnen. Hij vond een exploit, een tactiek waar AlphaStar niet op voorbereid was, en totaal niet effectief mee wist om te gaan. In de toekomst is het dan ook de zaak om de mogelijkheid van deze exploits uit te sluiten, zeker in de echte wereld. Met meer onderzoek en meer rekenkracht is het waarschijnlijk mogelijk om dit te bereiken. En zelf rijdende auto’s zijn slechts een van de mogelijke toepassingen van AI. Waarom niet een AI die zelf rijdende auto’s ontwerpt, bijvoorbeeld? Waarom niet een AI die het geneesmiddel voor kanker ontdekt? Wie weet wat er mogelijk is met voldoende onderzoek en technologische vooruitgang.

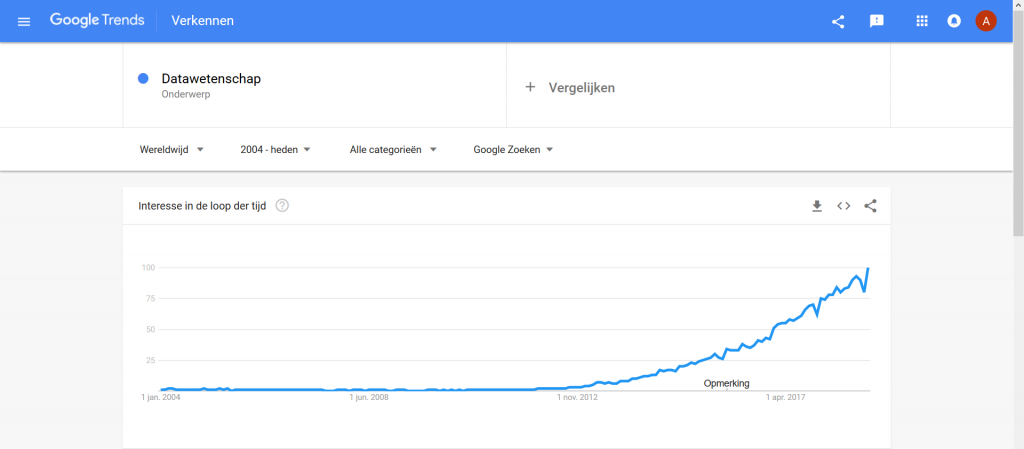

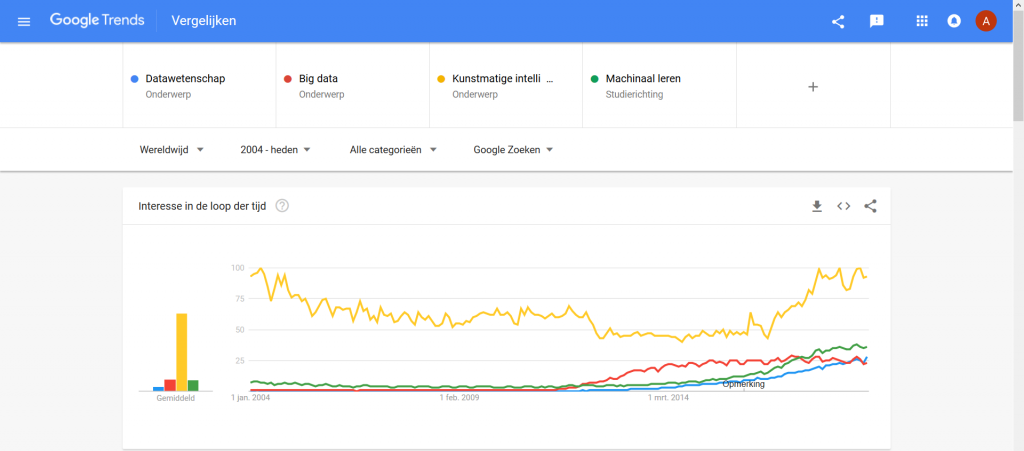

Daar zullen we echter gauw genoeg achter komen denk ik. AI neemt op het moment zijn eerste stapjes, maar het tempo van vooruitgang lijkt eerder exponentieel dan lineair te zijn. Maar, dat is alles voor nu.

Tot de volgende keer!

Bronnen

- DeepMind – AlphaStar: Mastering the Real-Time Strategy Game StarCraft II

- Youtube – DeepMind – DeepMind StarCraft II Demonstration

- Youtube – BrownBear – DeepMind AlphaStar Analysis and Impressions (StarCraft II)

- Youtube – ArtosisTV – The Pylon Show #36

- Wikipedia – AlphaZero

- Wikipedia – AlphaGo

Als we willen weten wat dit is dan kunnen we het testen met onze beslissingsboom. Is de snelheid hoger dan 60 km/u? Ja. Dus is het geen vogel en moeten we de vraag stellen: Is de lengte langer dan 3m? Nee. Dus het is ook geen vliegtuig, het is Superman!

Als we willen weten wat dit is dan kunnen we het testen met onze beslissingsboom. Is de snelheid hoger dan 60 km/u? Ja. Dus is het geen vogel en moeten we de vraag stellen: Is de lengte langer dan 3m? Nee. Dus het is ook geen vliegtuig, het is Superman!